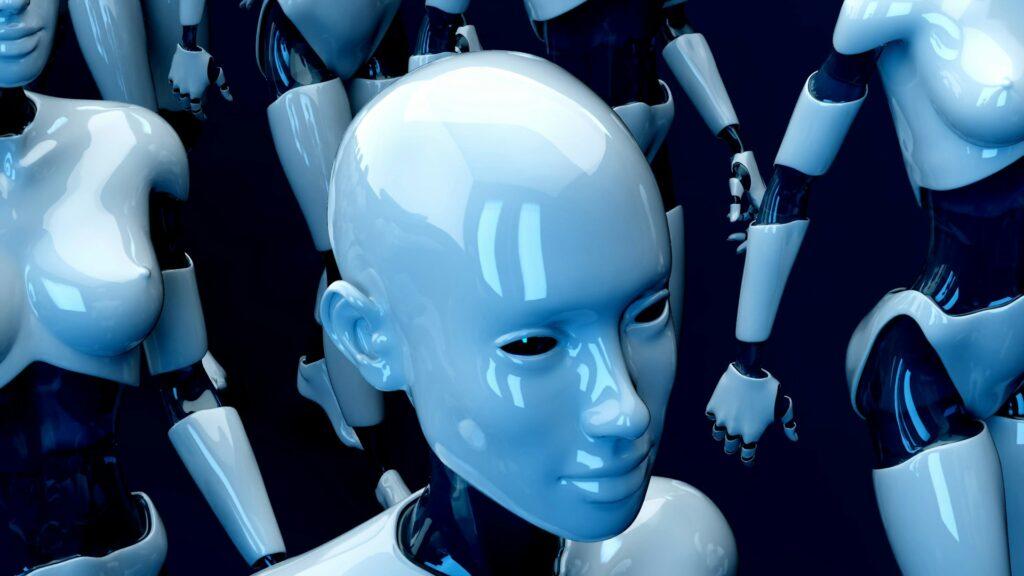

Bajban lehetnek hamarosan az AI-ra támaszkodó cégek

A mesterséges intelligencia (AI) világát egyre nagyobb kihívás elé állítja az a tény, hogy a valódi, ember által generált adatok kezdik kimeríteni magukat. A Business Insider cikke szerint a szintetikus adatok jelenthetnek megoldást, bár sok szakértő szkeptikus. Az olyan tech-óriások, mint az OpenAI és a Google, eddig az interneten elérhető szövegekre, videókra és egyéb médiatartalmakra támaszkodtak, hogy nagyméretű nyelvi modelljeiket (LLM) képezzék. Azonban a valódi adatok kínálata már csökken, és az előrejelzések szerint a szöveges adatok 2028-ra elfogyhatnak.

Belterjessé válhat az információforrás

Mivel a hagyományos adatforrások kimerülnek, egyre több vállalat fordul a szintetikus adatokhoz. Ezeket a mesterséges intelligencia rendszerek generálják, és a valós adatok alapján készülnek. Az Nvidia és a kínai Tencent technológiai óriás is fejlesztett olyan modelleket, amelyek képesek mesterséges adathalmazokat létrehozni. Azonban az ezzel kapcsolatos kutatások arra figyelmeztetnek, hogy a szintetikus adatok túlzott használata visszafordíthatatlan hibákat és modellösszeomlást okozhat – fejti ki a Business Insider.

Egy oxfordi és cambridge-i kutatócsoport tanulmánya szerint az AI által generált adatokkal táplált modellek halandzsát produkálhatnak. Gary Marcus, a New York-i Egyetem AI-elemzője szerint a szintetikus adatok nem képesek valódi érvelést vagy tervezést biztosítani. Jathan Sadowski, a Monash Egyetem senior elemzője a jelenséget „Habsburg AI”-nak nevezte el, utalva az osztrák dinasztiára, amelyet a belterjesség pusztított el.

Az AI-fejlesztők, mint például az OpenAI és a Google, hatalmas összegeket fizetnek a Reddit és más hírportálok adataiért, hogy friss adatokkal lássák el modelljeiket. Ha a valódi adatok kifogynak, a vállalatoknak a szintetikus adatokra kell támaszkodniuk. Egyes kutatások szerint a hibrid adatbázisok, amelyek vegyesen tartalmaznak valós és szintetikus adatokat, stabilabb alapot biztosíthatnak a modellek számára.

Az AI jövője szempontjából kritikus kérdés, hogy milyen arányban használják a szintetikus és valódi adatokat. Az áprilisi tanulmányok azt sugallják, hogy a saját generált adatokon edzett modellek nem feltétlenül omlanak össze, ha megfelelő arányban vegyesen kapnak valódi és szintetikus adatot.

Az AI fejlődése szempontjából elengedhetetlen, hogy a fejlesztők megtalálják az egyensúlyt a valós és szintetikus adatok között, hogy elkerüljék a modellek „mutálódását” és fenntartsák az AI rendszerek megbízhatóságát. A hibrid megközelítés lehet a kulcs a jövőbeli adatválság kezelésére.

Kapcsolódó cikkeink

PwC Global CEO Survey: Ötéves mélyponton a CEO-bizalom

🎧 Hallgasd a cikket: Lejátszás Szünet Folytatás Leállítás Nyelv: Auto…

Tovább olvasom >További cikkeink

Eladja a Nestlé jégkrémüzletágát, de marad a Froneri vegyesvállalatban

🎧 Hallgasd a cikket: Lejátszás Szünet Folytatás Leállítás Nyelv: Auto…

Tovább olvasom >Méltányosabb jövedelmet juttat a Lidl a kakaótermelőknek

🎧 Hallgasd a cikket: Lejátszás Szünet Folytatás Leállítás Nyelv: Auto…

Tovább olvasom >